En el mundo actual, la INTELIGENCIA ARTIFICIAL dejó de depender exclusivamente de la nube. Hoy es posible ejecutar modelos avanzados directamente en tu propia infraestructura, manteniendo control, privacidad y soberanía de datos. Comprender esta capacidad marca la diferencia entre quienes solo consumen servicios y quienes realmente dominan la tecnología.

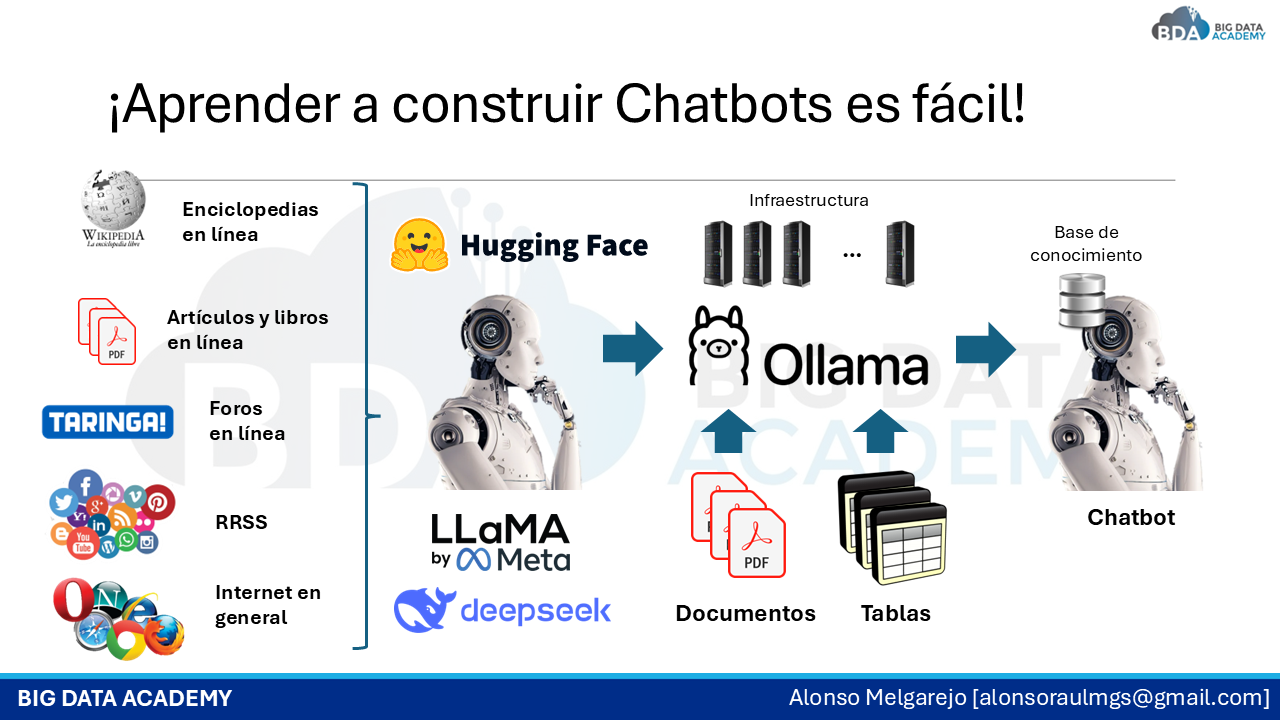

Muchas organizaciones enfrentan un desafío creciente: necesitan implementar soluciones de I.A. GENERATIVA sin exponer información sensible a proveedores externos. Sin embargo, pocos profesionales saben trabajar con modelos abiertos como LLAMA o DEEPSEEK, o utilizar repositorios como HUGGING FACE y OLLAMA para descargar y adaptar modelos de lenguaje. Esa brecha representa una gran oportunidad para quienes decidan prepararse.

Entender cómo funciona un modelo local, cómo ejecutarlo con OLLAMA y cómo integrarlo mediante frameworks como LANGCHAIN ya no es un conocimiento opcional. Es una competencia estratégica que permite desarrollar chatbots, asistentes internos y sistemas de consulta inteligente sin depender de servicios cloud.

Además, comprender arquitecturas como RAG (Generación aumentada por recuperación) en entornos 100% locales permite construir soluciones empresariales reales, donde el modelo se combina con bases de conocimiento privadas. Este enfoque abre la puerta a proyectos de alto valor en banca, gobierno e industria.

La necesidad es clara: quienes aprendan a trabajar con modelos de I.A. Generativa SIN NUBE no solo amplían su perfil técnico, sino que se posicionan como especialistas capaces de diseñar soluciones seguras, eficientes y alineadas con entornos regulados.

¿Y cómo puedo aprender todo esto? 👇