El BIG DATA es esencial en toda empresa, ya que no solo permite procesar grandes cantidades de datos, sino que también permite aplicar técnicas de optimización avanzadas.

Aunque es cierto que pocos profesionales saben de esto, este conocimiento es fácil de aprender, sólo debes de conocer las soluciones estándar y cómo aplicarlas en la empresa, esto justamente es lo que un INGENIERO DE DATOS hace, y parte de su trabajo como ingeniero, es evitar reinventar la rueda de nuevo, pero siendo muy técnicos, ¿cómo solucionarlo?

Los PATRONES DE DISEÑO y ARQUETIPOS son soluciones ESTÁNDAR para problemas comunes aplicables a cualquier realidad empresarial. Al adoptarlos, no solo ahorras tiempo, sino que también aseguras que tu código sea más robusto y eficiente. Además, te permiten centrarte en las partes innovadoras de tu trabajo, elevando la calidad general de tus proyectos.

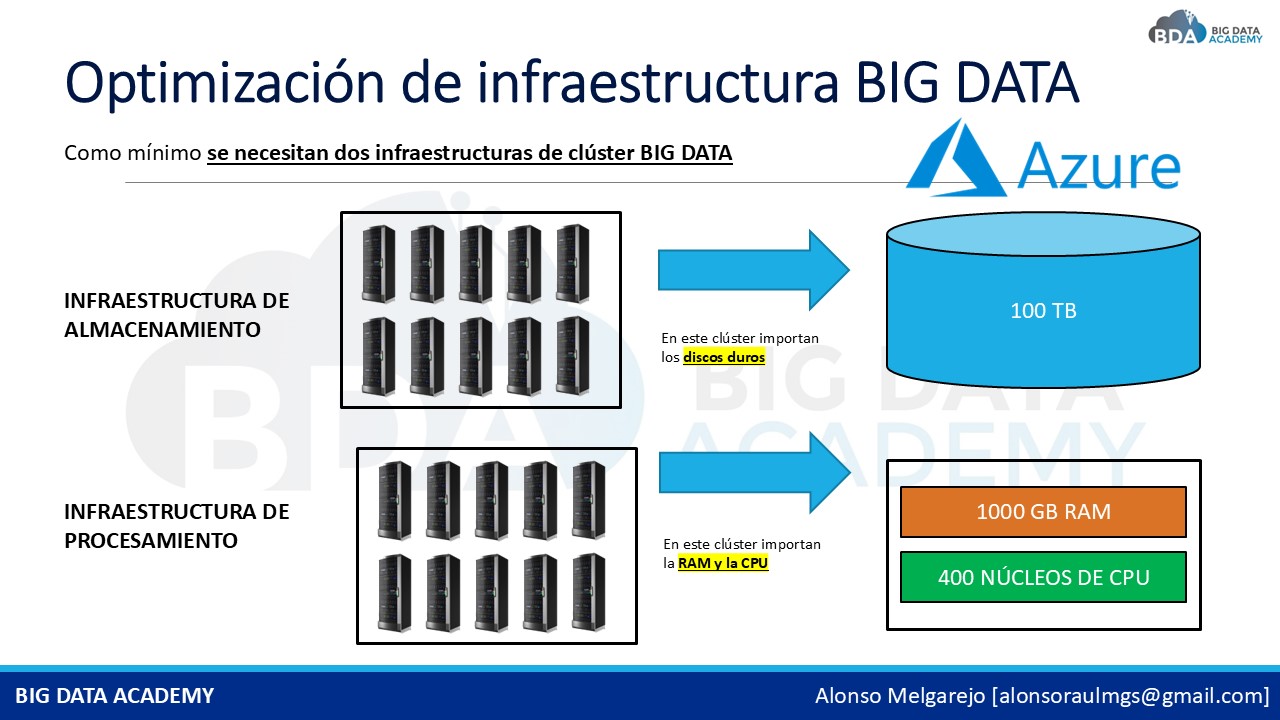

Implementar estos patrones te ayudará a OPTIMIZAR el uso de la RAM y la CPU en tus aplicaciones. Al utilizar soluciones probadas, reduces el consumo de recursos y mejoras los TIEMPOS de ejecución. Esto es esencial en un entorno como la empresa, donde la eficiencia y el rendimiento son clave para el éxito: No se trata solo de escribir código funcional, sino de crear software de ALTA CALIDAD.

Los ARQUETIPOS ofrecen una forma clara para estructurar tu código de manera efectiva. Siguiendo estos modelos, puedes acelerar el desarrollo y facilitar el mantenimiento a largo plazo. Adoptarlos es una forma inteligente de mejorar tus habilidades y aportar VALOR a tus proyectos.

En un mercado competitivo, dominar estos PATRONES DE DISEÑO y ARQUETIPOS te destaca como profesional, te permiten enfrentar desafíos complejos con soluciones eficientes y elegantes. Si buscas llevar tu carrera al siguiente nivel y destacar en tu campo, es el momento de incorporarlos en tu flujo de trabajo.

¿Y cómo puedo aprender todo esto? 👇