La idea de los chatbots no es nueva. Hace varios años ya existían herramientas que te permitían crear chatbots cargando preguntas, respuestas y algunos flujos de conversación. Eran sistemas bastante simples y formaban parte de lo que, alrededor de 2016, conocíamos como las inteligencias artificiales “clásicas”.

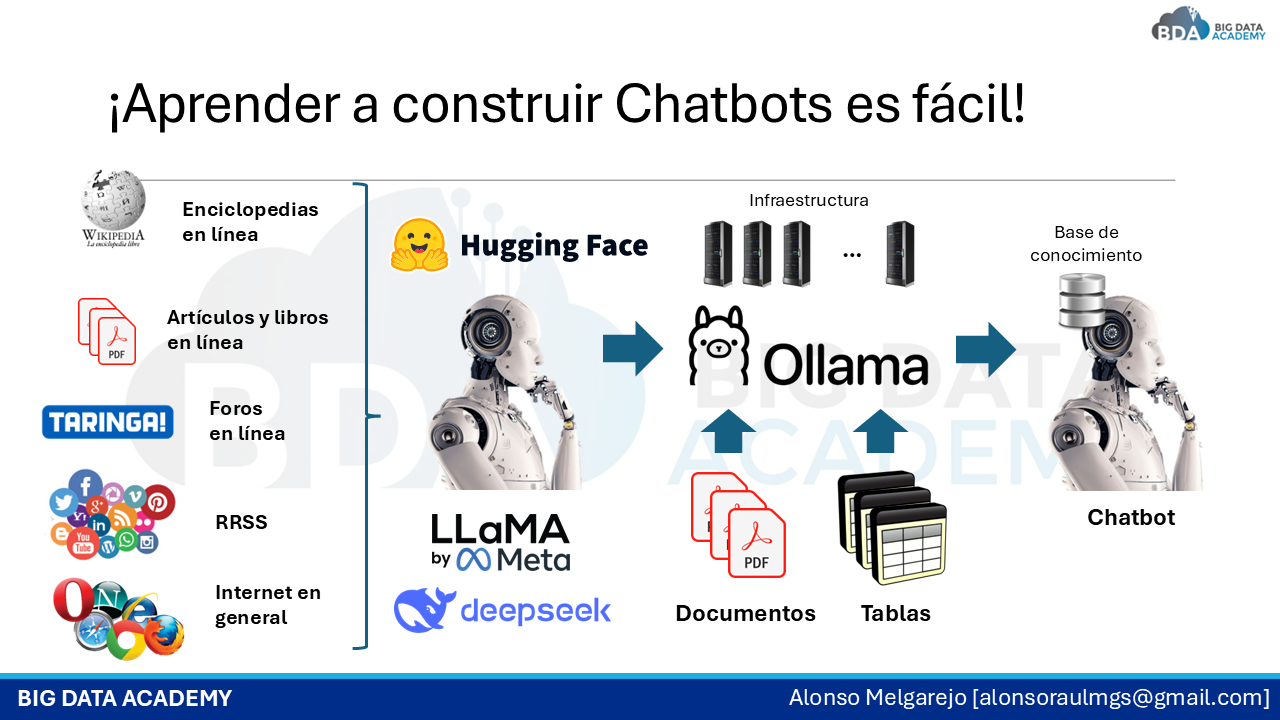

Con la llegada de los modelos de lenguaje modernos, el panorama cambió por completo. Hoy podemos construir chatbots que entienden mejor lo que les decimos, razonan y responden de forma mucho más natural. Y lo más interesante es que estas capacidades YA NO VIVEN SOLO EN LA NUBE. Ahora también es posible ejecutar estos modelos directamente en ON-PREMISE, es decir, en tus propios servidores o computadoras sin depender de una conexión a internet.

Esto es especialmente importante cuando se trabaja con INFORMACIÓN SENSIBLE o cuando no se quiere depender de servicios externos. Ejecutar la inteligencia artificial localmente permite tener MAYOR CONTROL sobre los datos, la infraestructura y los costos, sin dejar de aprovechar todo el potencial de la IA generativa actual.

Por supuesto, este avance también trajo nuevos retos. Hubo que lidiar con problemas como las ALUCINACIONES, la forma en que la IA recuerda información a corto y largo plazo, y cómo darle contexto cuando hay muchos datos involucrados. Para eso surgieron enfoques como las arquitecturas RAG/MCP y el uso de bases de datos vectoriales, que ayudan a que los chatbots encuentren la información correcta y respondan de manera más precisa.

¿Y cómo puedo aprender todo esto? 👇